OpenAIは、新しいフラッグシップモデル「GPT-4o」を発表しました。新しいモデルによって、音声、視覚、およびテキストをリアルタイムで処理することができ、人間とコンピュータのより自然な対話が実現されています。

GPT-4o(「o」は「オムニ」の略)は、テキスト、音声、画像を組み合わて入力し、同様にこれらを出力することが可能という点が大きな進化です。これまではテキストはテキスト、音声は音声であり、組み合わせて使う際にも、内部的には別々の物と処理されてきました。

音声入力に対しては232ミリ秒という短時間で応答でき、平均応答時間は320ミリ秒で、人間の会話における反応時間に匹敵します。また、GPT-4 Turboと同等の性能を持ち、特に非英語の反応速度が大幅に向上しているといい、日本語の応答速度は格段に向上している事が分かります。さらに、APIの費用も50%値下げされています。

OpenAI GPT-4o guessing May 13th's announcement from OpenAI on Vimeo.

モデルの能力と技術的な進歩

GPT-4oは、音声認識と視覚理解において既存のモデルを大幅に上回る性能を発揮します。具体的には、2つのGPT-4oが対話しながら歌ったり、インタビューの準備をしたり、リアルタイムで翻訳を行ったりするなど、多岐にわたる応用が可能です。また、音声入力と出力の両方において、トーンや複数の話者、背景音などの情報を直接観察・表現することができるため、より豊かな対話体験が実現します。

以前のGPT-4では、音声モードを使用することで音声入力を可能にしていましたが、平均応答時間はGPT-3.5で2.8秒、GPT-4で5.4秒でした。このプロセスでは、音声をテキストに変換するモデル、テキストを処理するGPT-3.5またはGPT-4、そしてテキストを再び音声に変換するモデルの3つのモデルが必要でした。このため、主要な知能部分であるGPT-4が音声のトーンや複数の話者、背景音などの情報を直接観察できず、表現の一部が失われていました。

一方、GPT-4oでは、テキスト、視覚、音声を統合的に処理する新しい単一モデルをエンドツーエンドで訓練しました。これにより、すべての入力と出力が同じニューラルネットワークによって処理されます。

モデル評価

GPT-4oは、テキスト、推論、およびコーディングの知能においてGPT-4 Turboレベルの性能を達成し、マルチリンガル、音声、および視覚の能力において新たな高水準を設定しています。特に、音声認識性能はWhisper-v3を大幅に上回り、低リソース言語においても優れた性能を発揮しています。

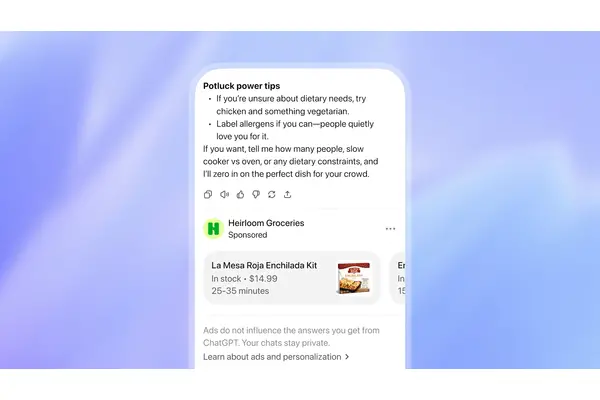

GPT-4oは、安全性を重視して設計されており、フィルタリングや行動修正の技術を通じて安全性を確保しています。また、70人以上の外部専門家によるテストを経て、バイアスや誤情報などのリスクを特定し、安全性の介入策を講じています。現在、テキストと画像入力およびテキスト出力が公開されており、音声出力は限定的に提供されています。

◆ ◆ ◆

GPT-4oは、ChatGPTの無料プランと有料ユーザー向けに順次提供されます。APIでは、テキストと視覚モデルとしてGPT-4oを利用でき、音声とビデオ機能のサポートも今後数週間で開始される予定です。